Pour Informer : YouTube fait appel à Wikipédia pour combattre le complotisme

Dans le Monde, cet article Par Pauline Croquet (Austin, Etats-Unis, envoyée spéciale) et Martin Untersinger (Austin, Etats-Unis, envoyé spécial). Le grand groupe spécialiste de la vidéo va bientôt afficher des extraits de l’encyclopédie en ligne sur les pages promouvant certaines théories du complot.

YouTube va s’attaquer aux fausses informations et, plus spécifiquement, aux théories du complot qui font florès sur la plate-forme.

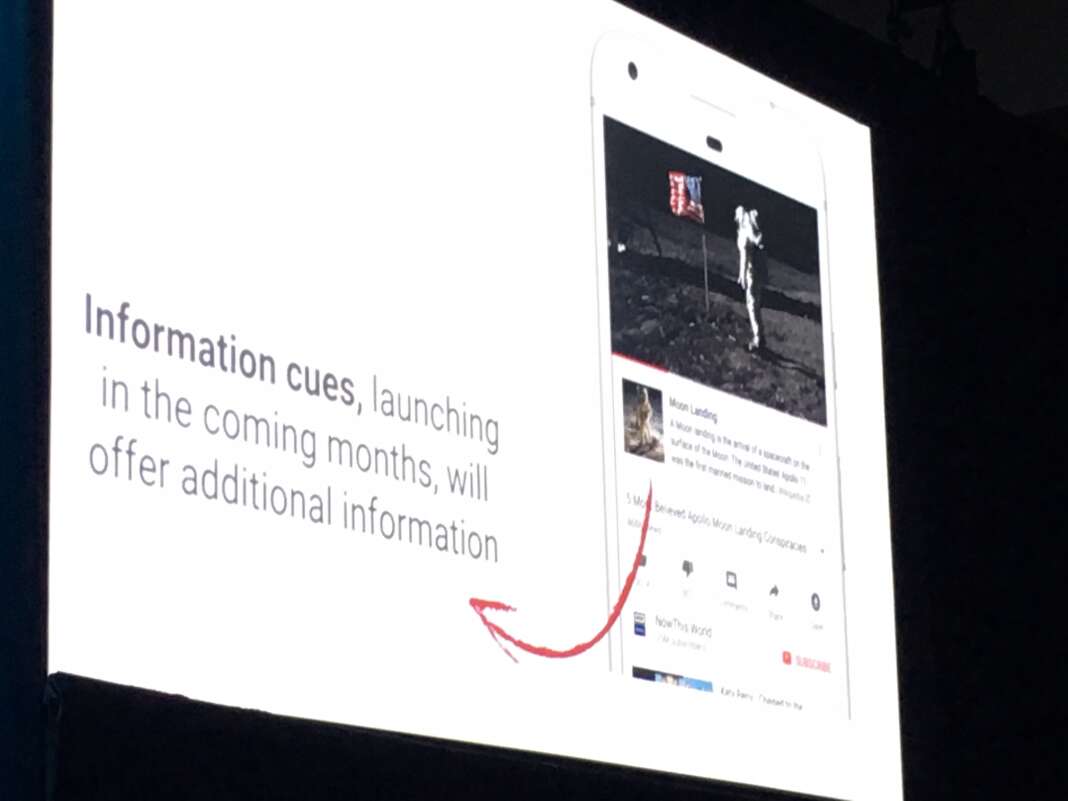

« Quand des vidéos porteront sur une théorie du complot, nous afficherons, à côté de la vidéo, des informations issues de Wikipédia au sujet de cet événement », a expliqué, mardi 13 mars, Susan Wojcicki, présidente-directrice générale du groupe spécialiste de la vidéo en ligne, lors d’une conférence dans le cadre du festival South by Southwest (SXSW) à Austin, au Texas.

A ce stade, la liste des théories du complot concernées sera issue, elle aussi, de Wikipédia et sera limitée à celles « qui font l’objet de discussions actives sur YouTube », a expliqué Susan Wojcicki. Cette dernière a donné deux exemples : l’idée selon laquelle l’homme n’a pas marché sur la Lune et celle qui veut que les traînées de condensation dans le sillage des avions de ligne sont des produits chimiques destinés à influencer la population (chemtrails). « Les gens pourront encore voir la vidéo, mais ils auront accès à des informations additionnelles sur lesquelles ils peuvent cliquer », a-t-elle expliqué.

La plate-forme régulièrement critiquée

YouTube – qui compte plus d’un milliard et demi d’utilisateurs – a été accusé ces derniers mois de propager toutes sortes de théories du complot. Notamment, récemment, de promouvoir des vidéos suggérant que les survivants de la tuerie du lycée de Parkland, en Floride, étaient des acteurs. Mais, bien au-delà, il lui a été reproché de favoriser des fausses informations et des contenus extrêmes ou violents.

Lire aussi : YouTube sanctionne une chaîne pour une vidéo conspirationniste sur la tuerie en Floride

Afficher des extraits de pages Wikipédia ne réglera sans doute pas ces enjeux plus larges. D’autant plus que ces « signaux d’information » (information cues) ne concernent pas ce que la plupart des experts considèrent être la source du problème : l’algorithme de recommandation. Ce dernier permet de suggérer à l’internaute des vidéos qu’il estime similaires à celle qu’il est en train de consulter et donc susceptibles de l’intéresser.

Plusieurs experts, dont un ancien ingénieur de YouTube, estiment que l’objectif principal est de faire en sorte que les utilisateurs visionnent des vidéos le plus longtemps possible. Ce système favoriserait ainsi les vidéos les plus accrocheuses, notamment celles… sur les théories du complot et les fausses informations.

Lire aussi : Face aux théories du complot sur YouTube, les « anticonspi » veulent « occuper le terrain »

Faire la différence entre héberger et promouvoir

YouTube a déjà ajusté ce système de recommandations et continue de le repenser, selon sa PDG :

« Nous cherchons à intégrer non seulement la satisfaction de l’utilisateur, mais aussi une forme de responsabilité dans notre système de recommandation. »

Celle-ci ajoute que son équipe réfléchit encore à ce que cela peut impliquer :

« Nous pensons à différents facteurs, comme la fiabilité du contenu, la valeur éducative… Sur les contenus d’actualité et de politique, nous voulons nous assurer que nous proposons une grande diversité de contenus et de sources. »

Pour autant Susan Wojcicki insiste : « Nous ne sommes pas un média, nous n’avons pas à dire si telle information est vraie ou fausse. » Selon elle, il n’appartient pas à YouTube de donner son avis sur les contenus à condition qu’ils ne contreviennent pas aux règles d’utilisation :

« Nous croyons fermement en la liberté d’expression, mais si un utilisateur franchit les limites des règles de la communauté à propos par exemple de discours haineux ou de violence, nous retirons la vidéo. »

Une ligne de conduite difficile à tenir quand les contenus flirtent avec les limites : « Nous en avons beaucoup discuté et nous en sommes venus pour l’instant à décider que nous laissons ce type de contenus hébergé sur la plate-forme mais que nous ne le promouvons pas, en désactivant les commentaires ou la monétisation. »

Tout au long de la conférence, Susan Wojcicki a régulièrement reconnu que 2017 avait été une année « compliquée et pleine de défis » face aux « fake news » et à la désinformation.

En savoir plus sur http://www.lemonde.fr/pixels/article/2018/03/14/pour-combattre-le-complotisme-youtube-fait-appel-a-wikipedia_5270459_4408996.html#317TAk4FSxhQrfvy.99